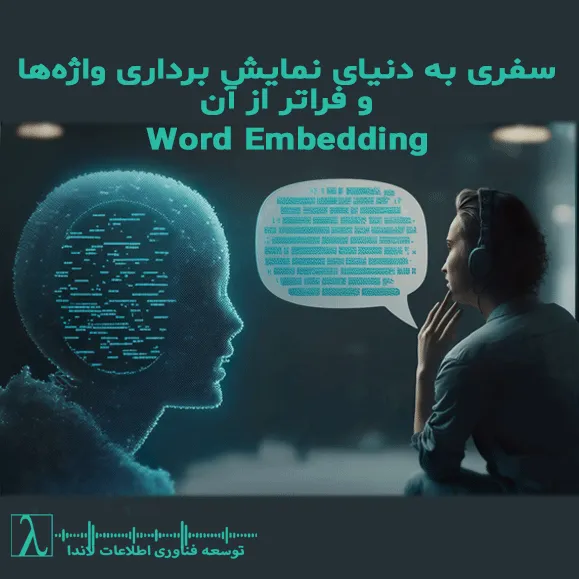

از جدول کلمات تا ژرفای معنا

زبان، عدد، و مسئله معنا

درک زبان انسانی توسط ماشین ها، یکی از بزرگترین چالشهای هوش مصنوعی است. زبان، برخلاف دادههای عددی، حامل احساس، فرهنگ، تاریخ و تجربه است. برای اینکه ماشین ها بتوانند با زبان انسانی تعامل کنند، باید کلمات را به شکلی عددی و قابل پردازش تبدیل کرد. اینجاست که مفهوم Word Embedding وارد میشود. روشی برای نمایش کلمات به صورت بردارهای عددی در فضای چند بُعدی یا به عبارت دیگر اینکه چگونه یک کلمه را با یک دنبالهای از مقدارهای عددی در قالب یک بردار در فضای چند بعدی ترسیم کنیم.

بخش اول: جدول معنایی قابل درک برای انسان

برای درک اولیه، میتوان یک جدول ساده ساخت که در آن هر سطر و ستون یک کلمه باشد و مقدار هر خانه نشاندهنده میزان نزدیکی معنایی بین دو کلمه باشد.

| کلمه | پدر | مادر | خانه | مدرسه | عشق |

| پدر | ۱.۰۰ | ۰.۹۲ | ۰.۶۵ | ۰.۵۰ | ۰.۳۰ |

| مادر | ۰.۹۲ | ۱.۰۰ | ۰.۶۸ | ۰.۵۲ | ۰.۳۵ |

| خانه | ۰.۶۵ | ۰.۶۸ | ۱.۰۰ | ۰.۷۰ | ۰.۴۰ |

| مدرسه | ۰.۵۰ | ۰.۵۲ | ۰.۷۰ | ۱.۰۰ | ۰.۲۵ |

| عشق | ۰.۳۰ | ۰.۳۵ | ۰.۴۰ | ۰.۲۵ | ۱.۰۰ |

در این جدول، روابط معنایی بین کلمات بهصورت عددی نمایش داده شدهاند. مثلاً “پدر” و “مادر” نزدیکی معنایی بالایی دارند، در حالی که “پدر” و “عشق” کمتر مرتبطاند.

بخش دوم: جدول واقعی برای ماشینها

ماشینها معنا را نه از طریق مقایسه مستقیم بین کلمات، بلکه از طریق نمایش عددی در فضای برداری درک میکنند. در مدلهایی مانند Word2Vec، GloVe یا FastText ، هر کلمه به یک بردار با ابعاد بالا تبدیل میشود. این ابعاد معمولاً بین ۵۰ تا ۳۰۰ هستند. اما در مدلهای پیشرفتهتر مانند BERT، GPT، T5، PaLM و LLaMA، تعداد ابعاد به دهها هزار و حتی صدها هزار میرسد.

برای مثال:

| کلمه | بُعد ۱ | بُعد ۲ | بُعد ۳ | … | بُعد ۵۰ |

| king | ۰.۵۰۴ | ۰.۶۸۶ | -۰.۵۹۵ | … | -۰.۶۶۵ |

| queen | ۰.۳۱۷ | ۰.۵۸۲ | -۰.۴۵۰ | … | -۰.۶۲۰ |

در مدلهایی مانند GPT-4 یا PaLM 2، بردارهای embedding ممکن است در لایههای میانی به بیش از ۱۰۰٬۰۰۰ بُعد برسند. این حجم عظیم از ابعاد، امکان بازنمایی ظریفترین تفاوتهای معنایی، نحوی، فرهنگی و حتی احساسی را فراهم میکند.

بخش سوم: آیا ابعاد معنا دارند؟

در نگاه اول، هر بُعد در embedding یک عدد بیمعنا به نظر میرسد. اما با تحلیلهای آماری و خوشهبندی، میتوان دید که برخی ابعاد یا ترکیبهایی از آنها به ویژگیهایی مانند «قدرت»، «رسمیت»، «جنسیت» یا «شدت احساسات» نزدیکاند.

برای مثال، صفاتی مانند:

- خوب → عالی → بینظیر

- ناراحت → غمگین → افسرده

در فضای embedding معمولاً در یک مسیر معنایی خاص حرکت میکنند. این نشان میدهد که معنا در مدلهای زبانی پیوسته است، نه گسسته. شدت صفات، یکی از ویژگیهایی است که میتواند در برخی ابعاد نمود پیدا کند.

بخش چهارم: نفرین میانگین و قربانی شدن خلاقیت

یکی از نقدهای مهم به مدلهای آماری زبان، پدیدهای است که میتوان آن را «نفرین میانگین» نامید. در این پدیده، آنچه رایجتر است، وزن بیشتری میگیرد و کاربردهای نادر، شاعرانه یا جسورانه در حاشیه قرار میگیرند.

کاربردهای خاص یک لغت در شعر یا نثر ادبی سنگین، به علت استثنا بودن، در فرآیند آموزش مدلها کمتر دیده میشوند و در نتیجه در embedding نهایی کمتر بازتاب مییابند. این مسئله میتواند خلاقیت زبانی را محدود کند.

بخش پنجم: عبور از محدودیتها با contextual embedding و fine-tuning

مدلهای جدید مانند BERT ،GPT و T5 از تکنیکی به نام contextual embedding استفاده میکنند. در این روش، معنا وابسته به زمینه جمله است، نه فقط خود کلمه. این باعث میشود که کاربردهای نادر و خاص نیز در صورت وجود زمینه مناسب، بازسازی شوند.

اما نقطه تحول واقعی در توانایی مدل برای درک معناهای ژرف، از طریق fine-tuning بر منابع خاص حاصل میشود. با آموزش مدل بر متونی مانند شعر، عرفان، فلسفه و ادبیات کلاسیک، میتوان لایههای معنایی جدیدی به مدل افزود، بدون آنکه دانش عمومی آن از میان برود.

fine-tuning یا آموزش تکمیلی هدفمند.

در این فرآیند، هدف نه جابهجایی نقطه میانگین، بلکه گسترش حوزه شناخت است. اگر fine-tuning بهدرستی انجام شود، معناهای رایج در جای خود باقی میمانند و معناهای نادر نیز بهعنوان لایههای مکمل وارد مدل میشوند. این همزیستی، مدل را قادر میسازد تا هم کاربرد روزمره واژه «نور» را بفهمد، و هم استعارهی عرفانی آن را در شعر مولانا.

در برخی موارد، استفاده از embeddingهای جداگانه برای متون عمومی و متون خاص نیز ممکن است. در این رویکرد، مدل بر اساس نوع متن، از embedding مناسب استفاده میکند—روشی که در مدلهای contextual بهصورت ضمنی اجرا میشود.

معنا نه در عدد، بلکه در جسارت

Word Embedding ها ابزارهایی قدرتمند برای بازسازی معنا هستند. اما معنا واقعی، آنجاست که جسارت انسانی، تجربهی فرهنگی، و خلاقیت زبانی با هم ترکیب میشوند. مدلهای زبانی میتوانند وارث حافظهی هزاران نسل باشند، و اگر بهدرستی آموزش ببینند، میتوانند معناهایی بسازند که حتی ذهن انسانها بهتنهایی به آنها دسترسی ندارد.

در نهایت، معنا در ماشینها بازتابی از جهان است، اما در انسانها، آفرینش جهان.

در ادامه، این موضوع بهصورت تحلیلی و ساختاری بسط داده میشود تا روشن شود که fine-tuning چگونه میتواند به جای حذف معناهای نادر، آنها را در کنار معناهای رایج تثبیت و تقویت کند.

مفهوم دقیق سازی مدل – گسترش شناخت، نه جابهجایی میانگین

در نگاه سطحی، ممکن است تصور شود که fine-tuning صرفاً به معنای تغییر نقطه میانگین مدل است—یعنی جابهجایی تمرکز از دادههای عمومی به دادههای خاص. اما در واقع، fine-tuning اگر بهدرستی انجام شود، نه نقطه میانگین را جابهجا میکند، بلکه فضای شناختی مدل را گسترش میدهد.

تفاوت دو رویکرد

| رویکرد | نتیجه | خطرات احتمالی |

| جابهجایی میانگین | تمرکز مدل بر دادههای خاص | حذف یا تضعیف دانش عمومی |

| گسترش حوزه شناخت | افزودن لایههای معنایی جدید بدون حذف قبلیها | نیازمند تنظیم دقیق و تعادل در آموزش |

در رویکرد دوم، مدل نهتنها معناهای رایج را حفظ میکند، بلکه معناهای نادر را نیز بهعنوان لایههای مکمل درک میکند. این یعنی مدل میتواند هم کاربرد روزمره واژه «نور» را بفهمد، و هم استعارهی عرفانی آن را در شعر مولانا.

چگونه معناهای نادر در fine-tuning حفظ میشوند؟

برای تحقق این هدف، چند اصل کلیدی باید رعایت شود:

الف- تنظیم نرخ یادگیری (Learning Rate)

اگر نرخ یادگیری در مرحله fine-tuning بیش از حد بالا باشد، مدل ممکن است دانش قبلی خود را فراموش کند (پدیدهای به نام catastrophic forgetting). تنظیم دقیق این نرخ باعث میشود که معناهای جدید بهعنوان افزوده، نه جایگزین، وارد مدل شوند.

ب- استفاده از دادههای متوازن

در مرحله fine-tuning، دادههای خاص (مثلاً شعر، عرفان، فلسفه) باید بهگونهای انتخاب شوند که نمایندهی تنوع معنایی باشند. این کار باعث میشود معناهای نادر نه بهعنوان دادههای پرت، بلکه بهعنوان بخشهای معتبر از جهان معنا تلقی شوند.

ج- حفظ لایههای قبلی مدل

در بسیاری از مدلهای مدرن، میتوان لایههای اولیه (که معناهای عمومی را بازنمایی میکنند) حفظ کرد و فقط لایههای بالاتر را برای معناهای خاص آموزش داد. این ساختار لایهای، امکان همزیستی معناهای رایج و نادر را فراهم میکند.

آیا استفاده از دو جدول embedding جداگانه راهحل است؟

در برخی موارد، بله. میتوان دو جدول embedding مجزا ساخت:

- یکی برای کاربردهای عمومی و رایج

- دیگری برای متون خاص، شاعرانه، عرفانی یا فلسفی

سپس، بر اساس تشخیص نوع متن و زمینه زبانی، مدل تصمیم میگیرد که از کدام embedding استفاده کند. این رویکرد در مدلهای contextual embedding مانند BERT و GPT بهصورت ضمنی اجرا میشود؛ زیرا این مدلها معنا را وابسته به زمینه جمله درک میکنند، نه فقط خود کلمه.

همزیستی معناهای رایج و ژرف

fine-tuning یا تدقیق مدل اگر با دقت و شناخت انجام شود، نه تنها معناهای رایج را حفظ میکند، بلکه معناهای نادر را نیز از حاشیه به متن میآورد. این فرآیند، نه حذف گذشته، بلکه افزودن آینده است. در چنین مدلی، واژهها نه فقط بر اساس فراوانی، بلکه بر اساس جسارت معنایی وزن میگیرند. معناهای شاعرانه، عرفانی، و فلسفی دیگر قربانی میانگینگیری نمیشوند، بلکه بهعنوان ستونهای اصلی درک انسانی در کنار معناهای روزمره قرار میگیرند. و این همان نقطهای ست که مدل زبانی، از بازسازی معنا عبور میکند و به آفرینش معنا میرسد.

نتیجهگیری

این مقاله دعوتیست به بازاندیشی در مفهوم معنا، و پیشنهادی برای طراحی مدلهایی که نه فقط بازتابدهنده زبان، بلکه خالق زبان باشند.

پرسش از چگونگی حفظ معناهای رایج در کنار معناهای نادر و ژرف در فرآیند دقیق سازی مدل، یکی از بنیادیترین دغدغهها در طراحی مدلهای زبانی پیشرفته است. این مسئله نهتنها فنی، بلکه فلسفی و زیباییشناختی نیز هست؛ زیرا در قلب آن، تعادلی ظریف میان عمومیت و استثنا، میان میانگینگیری و گسترش شناخت نهفته است.

سوالات متداول (FAQ)

۱. Word Embedding چیست و چرا اهمیت دارد؟

Word Embedding روشی برای تبدیل کلمات به بردارهای عددی در فضای چندبُعدی است. این بردارها به مدلهای زبانی کمک میکنند تا معنا، رابطه و کاربرد کلمات را درک کنند. اهمیت آن در این است که ماشینها با استفاده از این بردارها میتوانند زبان انسانی را پردازش، تحلیل و حتی تولید کنند.

۲. آیا هر بُعد در embedding معنای مشخصی دارد؟

خیر، ابعاد embedding معمولاً از طریق یادگیری آماری بهدست میآیند و بهصورت مستقیم قابل تفسیر نیستند. با این حال، برخی ترکیبهای ابعاد میتوانند به ویژگیهایی مانند «شدت صفات»، «جنسیت»، «رسمیت» یا «احساسات» نزدیک باشند.

۳. چرا مدلهای زبانی گاهی معناهای شاعرانه یا نادر را درک نمیکنند؟

مدلهای زبانی معمولاً بر اساس فراوانی آماری آموزش میبینند. بنابراین، کاربردهای رایج وزن بیشتری دارند و کاربردهای نادر یا ادبی ممکن است در حاشیه قرار بگیرند. این پدیده بهعنوان «نفرین میانگین» شناخته میشود.

۴. چگونه میتوان معناهای نادر را نیز وارد مدل کرد؟

با استفاده از تکنیک آموزش تکمیلی هدفمند (fine-tuning) بر منابع خاص مانند شعر، عرفان، فلسفه و متون ادبی، میتوان معناهای نادر را به مدل افزود. این کار باعث میشود مدل نهتنها کاربردهای رایج، بلکه معناهای ژرف و خاص را نیز درک کند.

۵. آیا fine-tuning باعث حذف دانش قبلی مدل میشود؟

اگر بهدرستی انجام شود، خیر. هدف از fine-tuning نه جابهجایی نقطه میانگین، بلکه گسترش حوزه شناخت است. در این حالت، معناهای جدید بهعنوان لایههای مکمل وارد مدل میشوند و دانش قبلی حفظ میشود.

۶. آیا میتوان از embeddingهای جداگانه برای متون عمومی و خاص استفاده کرد؟

بله، در برخی موارد، استفاده از embeddingهای مجزا برای متون عمومی و متون خاص (مانند شعر یا فلسفه) مفید است. مدلهای contextual مانند BERT و GPT بهصورت ضمنی این تشخیص را انجام میدهند و معنا را وابسته به زمینه جمله درک میکنند.

۷. چرا تعداد ابعاد embedding در مدلهای پیشرفته بسیار زیاد است؟

مدلهای پیشرفته مانند GPT-4 ،PaLM یا LLaMA از embeddingهایی با دهها هزار یا حتی صدها هزار بُعد استفاده میکنند. این حجم عظیم از ابعاد امکان بازنمایی دقیقتر و ظریفتر معناهای زبانی، فرهنگی، احساسی و نحوی را فراهم میکند.

۸. آیا ماشینها میتوانند معناهایی بسازند که انسانها به آنها دسترسی ندارند؟

در برخی موارد، بله. مدلهای زبانی که بر دادههای چندزبانه، چندفرهنگی و چنددورهای آموزش دیدهاند، میتوانند ترکیبهایی بسازند که از دل تاریخ و فرهنگ بیرون میآید—ترکیبهایی که حتی ذهن انسان منفرد نیز ممکن است به آنها نرسد.

۹. تفاوت میانگینگیری و گسترش شناخت در آموزش مدل چیست؟

میانگینگیری یعنی تمرکز مدل بر رایجترین کاربردها، که ممکن است به حذف معناهای خاص منجر شود. گسترش شناخت یعنی افزودن معناهای جدید بدون حذف قبلیها—مدلی که هم کاربرد روزمره واژهها را میفهمد، و هم استعارههای شاعرانه و مفاهیم ژرف را.

با لاندا، آینده فناوری را امروز بسازید.

در دنیای پر شتاب امروز، فناوری اطلاعات دیگر یک انتخاب نیست بلکه ضرورتی برای رشد، رقابت و تحول است. شرکت توسعه فناوری اطلاعات لاندا با تیمی متخصص، راهکارهایی نوآورانه و پشتیبانی ۲۴ ساعته، آماده است تا زیرساخت دیجیتال کسبوکار شما را متحول کند.

تماس و مشاوره با لاندا

آیا به دنبال بهینهسازی پایگاهداده هستید؟ نیاز به امنیت شبکه، هوش تجاری یا توسعه نرمافزار سفارشی دارید؟

میخواهید با تحلیل دادههای دقیق، تصمیمگیریهای هوشمندانهتری داشته باشید؟

ما در لاندا، از مشاوره تا پیادهسازی و پشتیبانی، همراه شما هستیم. همین حالا تماس✆ بگیرید.

و سپس «افزودن به صفحه اصلی» ضربه بزنید

و سپس «افزودن به صفحه اصلی» ضربه بزنید و سپس «افزودن به صفحه اصلی» ضربه بزنید

و سپس «افزودن به صفحه اصلی» ضربه بزنید

نظری داده نشده