در بسیاری از سازمانها، پروژههای Power BI بهظاهر خوب شروع میشوند، اما پس از چند ماه، با چالشهای جدی روبهرو میشوند. یکی از این چالشها مدیریت و بهینهسازی Dataflow در پروژهها است.

- هر تیم نسخه خودش از داده و KPI را دارد.

- چند فایل PBIX شامل Queryهای مشابه با تفاوتهای جزئی

- Refresh زمانبر و سنگین روی سیستم کاربران

- عدم همزمانی و تضاد در گزارشها

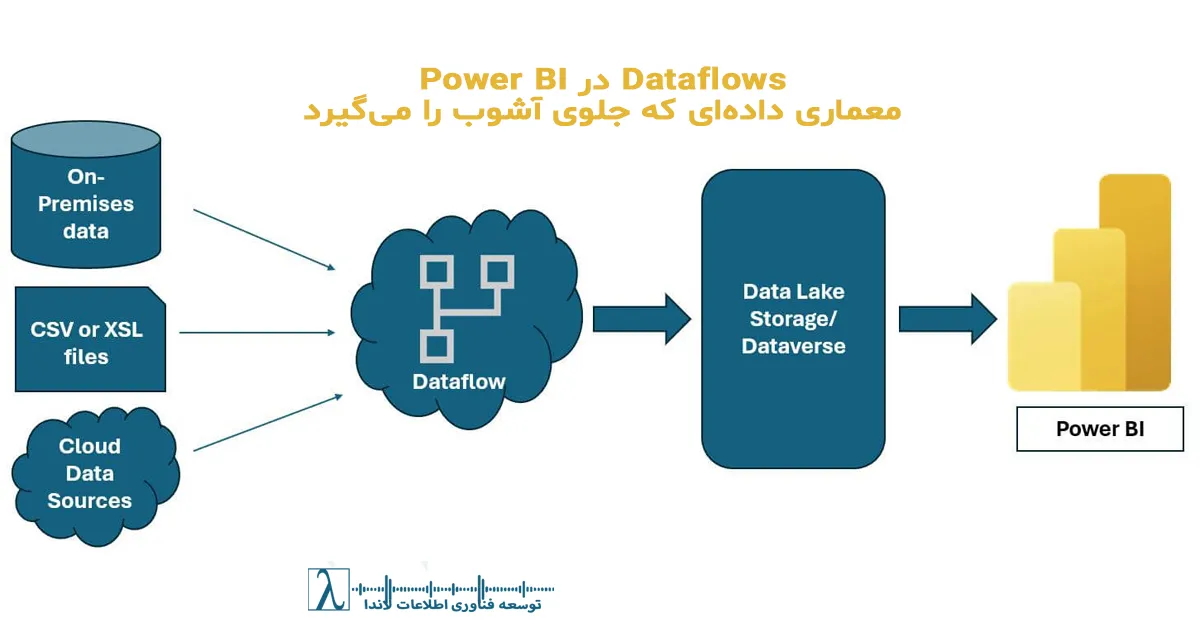

این مشکل ریشه در نبود یک لایه ETL سازمانی مشترک دارد. جاییکه داده قبل از ورود به مدل، پاکسازی، استاندارد و یکپارچه شود. اینجا است که Dataflows نقش حیاتی پیدا میکنند.

Dataflow دقیقاً چیست؟

Dataflow را میتوان اینگونه تعریف کرد:

«یک لایه سرویسمحور برای مدلسازی داده که به جای Power BI Desktop، در فضای ابری مدیریت و نگهداری میشود.»

Dataflowها شامل مجموعهای از جداول هستند که منطق Power Query (M) در آنها ذخیره شده است. این جداول میتوانند توسط چندین گزارش و چندین مدل بدون تکرار محاسبات مصرف شوند.

Dataflow = ETL as a Shared Service

چرا Dataflow از نظر معماری اهمیت دارد؟

تصور کنید سازمان شما ۱۰ تیم تحلیلگر دارد. اگر هر تیم مستقیماً از دیتابیس اصلی Query بگیرد:

- بار عملیاتی روی دیتابیس بالا میرود.

- هر تیم اسکریپتهای ETL متفاوتی میسازد.

- هر گزارش تعریف متفاوتی از “Revenue” یا “Customer” ارائه میدهد.

اما با Dataflow:

| قابلیت | نتیجه |

|---|---|

| محاسبه یکبار و اشتراکپذیر | حذف تکرار و ناسازگاری |

| اجرای ETL روی سرویس ابری | کاهش فشار از دیتابیس عملیاتی |

| ذخیره پایدار روی Data Lake | آماده برای پردازشهای پیشرفته |

معماری استاندارد Dataflow در سازمان (نسخه حرفهای)

بهجای ساخت یک Dataflow بزرگ، باید معماری لایهای ایجاد کنیم:

[Raw / Ingest]

↓

[Clean / Standardize]

↓

[Conformed / Business Layer]

↓

[Reporting (Semantic Models)]

توضیح:

| لایه | کاربرد | مثال |

|---|---|---|

| Raw | ورود داده خام بدون تغییر | جدول فروش خروجی DB |

| Clean | حذف نویز + تایپ استاندارد | تبدیل تاریخ، حذف null |

| Conformed | تعریف مفاهیم سازمانی | Customer، Product، Calendar |

| Reporting | خروجی مصرف برای مدل | FactSales، DimProduct |

این ساختار نه تنها کیفیت داده را بالا میبرد، بلکه نسخه منبع واحد (Single Source of Truth) ایجاد میکند.

نمونه سناریوی واقعی (غیرتکراری)

وضعیت ابتدایی:

- تیم فروش، مالی و پشتیبانی هر کدام گزارش مستقل دارند.

- KPIها اختلاف دارد (Revenue در یک گزارش Gross است و در دیگری Net).

- زمان Refresh مجموعه گزارشها بیش از ۴۵ دقیقه است.

راهکار:

- ایجاد Dataflow لایهای برای Customer، Product، Sales و SupportTickets

- حذف Transformation از داخل PBIXها و انتقال آن به Dataflow

- اتصال همه مدلها به Business Layer مشترک

نتیجه:

| قبل | بعد |

|---|---|

| KPIهای متفاوت | تعریف مفاهیم استاندارد و یکپارچه |

| Refresh سنگین روی Desktop | پردازش ابری و زمان Refresh کمتر |

| نگهداری سخت | مدیریت متمرکز و قابل Audit |

ویژگیهای پیشرفتهای که بسیاری استفاده نمیکنند.

| قابلیت | توضیح |

|---|---|

| Incremental Refresh | بارگذاری فقط دادههای جدید، مناسب برای Factهای حجیم |

| Enhanced Compute Engine | افزایش سرعت Join / Group / Aggregation |

| CDM Storage در ADLS Gen2 | سازگاری با Synapse و Fabric |

| API + PowerShell | مدیریت نسخه و اتوماسیون CI/CD |

نکته مهم: اگر حجم داده بالاست، حتماً Enhanced Compute را فعال کنید.

مزایا و معایب: نسخه کاربردی و سازمانی

مزایا:

- استانداردسازی مفاهیم کلیدی کسبوکار

- کاهش استفاده از منابع Desktop

- مشارکت همزمان چند واحد سازمانی روی داده واحد

- سازگاری عالی با Azure Stack (Synapse / Data Lake / Fabric)

معایب:

- نیاز به معماری درست از ابتدا

- برای دادههای بسیار حجیم، به Premium نیاز است

- ممکن است نیاز به Data Steward / Owner مشخص باشد

بهترین توصیههای طراحی: تجربه عملی لاندا

| مورد | توصیه |

|---|---|

| Naming Convention | از پیشوندهای stg_, trf_, dim_, fact_ استفاده کنید |

| Version Control | اسکریپتهای M را در Git نگهداری کنید |

| Refresh Schedule | Factها چندبار در روز، Dimensions روزانه کافی است |

| Documentation | هر Entity باید تعریف کسبوکاری واضح داشته باشد |

نتیجهگیری

Dataflowها فقط “یک قابلیت دیگر در Power BI” نیستند. اگر درست طراحی شوند، تبدیل میشوند به:

- هسته معماری تحلیلی سازمان

- پشتوانه قابلاعتماد KPIها

- عامل حذف دوبارهکاری و اختلاف گزارشات

و اگر طراحی نشوند؟

نتیجه همان بینظمی، تناقض و هزینه پنهان بالا خواهد بود.

منابع و آموزشهای تخصصی Power BI

- کتاب “ کتاب مرجع زبان DAX“ به قلم روزبه امیرعصامی

- کتاب طراحی داشبوردهای مدیریتی به قلم روزبه امیرعصامی

- توابع پیشرفته DAX در Power BI

تماس و مشاوره با لاندا

اگر سازمان شما:

- چندین فایل PBIX مشابه دارد،

- KPIها بین واحدها ناسازگار هستند،

- Refresh کند و پرهزینه است،

لاندا معماری Dataflow سازمانی + Semantic Layer را برای شما طراحی و پیادهسازی میکند.

و سپس «افزودن به صفحه اصلی» ضربه بزنید

و سپس «افزودن به صفحه اصلی» ضربه بزنید و سپس «افزودن به صفحه اصلی» ضربه بزنید

و سپس «افزودن به صفحه اصلی» ضربه بزنید

نظری داده نشده